?近期,實驗室博士生李亞瓊作為第一作者的論文“DeMod: A Holistic Tool with Explainable Detection and Personalized Modification for Toxicity Censorship”被The ACM Conference on Computer-Supported Cooperative Work and Social Computing (CSCW) 會議錄用。面對在線社區(qū)毒性內(nèi)容審查,用戶有多樣性的需求,如結(jié)果理解和內(nèi)容修改等。針對這一問題,我們進(jìn)行了形成性研究,調(diào)查社交用戶對毒性內(nèi)容審查的不同需求及相應(yīng)的設(shè)計期望,并構(gòu)建了基于ChatGPT的審查工具DeMod。DeMod具有可解釋性檢測和個性化修改功能,可以向社交用戶提供毒性內(nèi)容的細(xì)粒度檢測結(jié)果、詳細(xì)的結(jié)果解釋和個性化修改建議。最后,自動評估和人類評估相結(jié)合的驗證結(jié)果表明了DeMod在功能豐富性、審查準(zhǔn)確性和工具易用性等方面的優(yōu)勢。基于這些發(fā)現(xiàn),我們進(jìn)一步提出了對未來內(nèi)容審查系統(tǒng)設(shè)計的見解。

期刊簡介

The ACM Conference on Computer-Supported Cooperative Work and Social Computing (CSCW) 會議是人機(jī)交互與普適計算方向的權(quán)威國際學(xué)術(shù)會議(CCF A類推薦國際會議),涵蓋了計算機(jī)網(wǎng)絡(luò)與通信技術(shù)、多媒體技術(shù)、社會學(xué)、心理學(xué)、管理科學(xué)等多門學(xué)科的綜合應(yīng)用,在人機(jī)交互領(lǐng)域享有很高的學(xué)術(shù)聲譽(yù)。該會議計劃于2025年10月18日至10月22日在挪威卑爾根召開。

論文簡介

DeMod:具備可解釋檢測和個性化修復(fù)的毒性內(nèi)容審查工具

如今,社交媒體已成為用戶自我披露的熱門平臺,如數(shù)億人每天通Twitter、Facebook和微博記錄生活、表達(dá)觀點(diǎn)、與朋友互動。盡管社交媒體的開放性為內(nèi)容分享提供了廣闊空間,也導(dǎo)致了毒性內(nèi)容的披露。所謂毒性內(nèi)容,是指“可能導(dǎo)致他人退出討論的粗魯、不尊重或不合理的評論”,包括仇恨言論、騷擾、侮辱及虐待和攻擊性言論等。由于語境崩塌現(xiàn)象,用戶通常未意識到自己正在披露毒性內(nèi)容。研究發(fā)現(xiàn),約三分之二的毒性內(nèi)容屬于隱性毒性,而用戶往往對這些言論產(chǎn)生的傷害并不自知。另有研究表明,23.00%的用戶在回顧自己發(fā)布的內(nèi)容時感到后悔,原因包括未考慮后果、文化誤判、意外受眾和平臺規(guī)范誤解等。為避免毒性內(nèi)容披露,社交媒體用戶通常在發(fā)布前進(jìn)行審查,如自我審查或借助自動化工具等方式。研究發(fā)現(xiàn),社交用戶常通過檢查、調(diào)整或刪除部分內(nèi)容來確保其適合發(fā)布。盡管已有多種毒性內(nèi)容審查方法,但是絕大多數(shù)聚焦于檢測毒性內(nèi)容,如使用Perspective API 評估毒性分?jǐn)?shù)或使用RECAST工具識別毒性關(guān)鍵詞。然而,毒性內(nèi)容審查是一個復(fù)雜過程,檢測只是一個初步的任務(wù),社交用戶可能需要理解檢測結(jié)果和修改內(nèi)容。例如,盡管RECAST工具能幫助用戶識別毒性詞匯,但用戶常因知識或經(jīng)驗不足,不知如何降低其毒性。因此,需要一個整體的自動化工具,幫助用戶完成毒性內(nèi)容檢測、內(nèi)容修改等多項審查任務(wù)。

構(gòu)建一個整體性毒性內(nèi)容審查工具面臨諸多挑戰(zhàn)。首先,社交用戶對毒性內(nèi)容審查的多樣化需求尚不明確。正如前述,用戶可能對工具有不同功能要求,如提供豐富的解釋和修改建議。因此,在研究毒性內(nèi)容審查工具時,需系統(tǒng)調(diào)查用戶的審查需求;其次,設(shè)計和實現(xiàn)一個符合社交用戶整體性需求的毒性審查工具并非易事。該工具應(yīng)具備多重目標(biāo),如提供精準(zhǔn)檢測、細(xì)粒度結(jié)果和個性化修改,如何實現(xiàn)不同功能并高效整合是一個巨大挑戰(zhàn)。第三,面向這一多功能的毒性內(nèi)容審查工具的實際評估較為困難。為了驗證工具在幫助社交用戶審查毒性內(nèi)容方面的表現(xiàn),需在真實社交媒體場景中進(jìn)行長期評估,而且像個性化修改等效果缺少量化的檢測指標(biāo),難以評估。

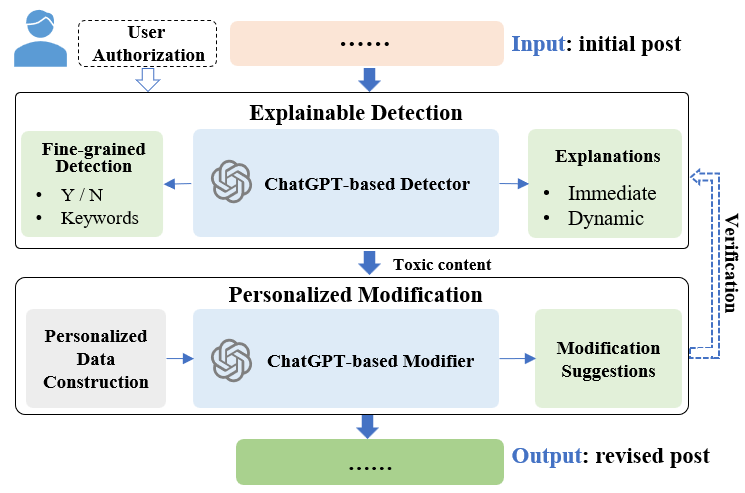

針對上述問題與挑戰(zhàn),我們設(shè)計了一個幫助社交媒體用戶進(jìn)行毒性內(nèi)容審查的工具DeMod,具備可解釋檢測和個性化修改等多功能。首先,我們在中國流行的社交平臺——微博上進(jìn)行需求調(diào)研,通過問卷調(diào)查和訪談,我們揭示了社交用戶的毒性內(nèi)容審查實踐、遇到的問題以及對毒性內(nèi)容審查工具的設(shè)計期望,并提出五個設(shè)計目標(biāo):提供整體性審查、提供細(xì)粒度檢測結(jié)果、增強(qiáng)可解釋性、給予個性化修改建議、確保用戶控制權(quán)。其次,基于五項目標(biāo),我們設(shè)計并實現(xiàn)了一個名為DeMod的整體性自動化毒性內(nèi)容審查工具,如下圖所示。DeMod本質(zhì)是一個基于ChatGPT增強(qiáng)的內(nèi)容審查工具,配備了可解釋檢測器(Explainable Detector)和個性化修改器(Personalized Modifier)模塊。可解釋檢測器提供即時解釋(Immediate Explanation)和動態(tài)解釋(Dynamic Explanation)結(jié)果。即時解釋通過關(guān)鍵詞或毒性原因向用戶提供說明當(dāng)前檢測內(nèi)容為何具有毒性,動態(tài)解釋則通過模擬受眾對即將發(fā)布的內(nèi)容的態(tài)度,幫助社交用戶了解當(dāng)前內(nèi)容的潛在影響。兩種解釋旨在增強(qiáng)社交用戶對毒性內(nèi)容的理解,進(jìn)而促使用戶的發(fā)布前審查和自我調(diào)節(jié)行為。在此之后,個性化修改器根據(jù)社交用戶的多重需求提供修改建議,包括去除毒性、保留原意、以及體現(xiàn)用戶的個性化語言風(fēng)格。通過這些功能,社交用戶可以更高效、靈活地進(jìn)行內(nèi)容審查。第三,我們以微博為研究平臺,將DeMod作為第三方工具實現(xiàn),并招募35名參與者對DeMod的功能、效果、設(shè)計三個維度進(jìn)行了綜合的評估,結(jié)果表明DeMod在毒性內(nèi)容審查方面表現(xiàn)出色,并獲得參與者的高度認(rèn)可。基于以上研究與結(jié)果,我們還提出了若干關(guān)于內(nèi)容審查工具設(shè)計的見解,包括從全局視角增強(qiáng)審查工具設(shè)計、重視過程和結(jié)果可解釋性、提供個性化改進(jìn)措施,以幫助用戶發(fā)布更合適的內(nèi)容。

圖1 DeMod框架設(shè)計

模型構(gòu)造

1. 可解釋檢測器(Explainable Detector):實證研究表明,用戶希望在毒性內(nèi)容審查中獲得細(xì)粒度的檢測結(jié)果和解釋性反饋。因此,我們設(shè)計了基于ChatGPT的可解釋檢測器。首先,該工具輸出毒性檢測結(jié)果,包括分類結(jié)果(是否含有毒性內(nèi)容)以及相關(guān)的關(guān)鍵詞。分類結(jié)果告知用戶當(dāng)前帖子是否包含毒性內(nèi)容,如果是,工具會高亮顯示引發(fā)毒性的關(guān)鍵詞,以增強(qiáng)用戶對毒性細(xì)節(jié)的感知。在此基礎(chǔ)上,檢測器提供即時和動態(tài)解釋。即時解釋說明帖子及關(guān)鍵詞為何具有毒性;動態(tài)解釋則通過利用ChatGPT的角色模擬能力預(yù)測受眾對帖子的態(tài)度和意見,幫助用戶了解內(nèi)容可能產(chǎn)生的社會影響。這一設(shè)計契合基本人類價值理論,強(qiáng)調(diào)個體行為易受他人價值觀的影響,包括他人的態(tài)度、個人信息等。為確保用戶的自主性,DeMod允許用戶手動選擇受眾角色,如父母、朋友甚至陌生人,并進(jìn)行態(tài)度模擬。一旦選擇了受眾,DeMod便會模擬該角色對帖子的態(tài)度。上述檢測及解釋任務(wù)均基于ChatGPT模型實現(xiàn)。

2. 個性化修改器(Personalized Modifier):實證研究表明,用戶希望修改建議不僅能幫助他們?nèi)コ又械亩拘詢?nèi)容,還能盡量保留原帖的語義和用戶的個性化語言風(fēng)格。我們發(fā)現(xiàn),直接使用類似于檢測任務(wù)的提示詞讓大模型執(zhí)行毒性內(nèi)容修改任務(wù)具有挑戰(zhàn)性,很難同時實現(xiàn)這些多重目標(biāo)。然而,大模型具備小樣本學(xué)習(xí)能力,即Few-shot Learning。如果提供一些展示原始帖子(包含毒性內(nèi)容)與相應(yīng)修改后的內(nèi)容(去除毒性但保留相似語義和用戶語言風(fēng)格)的示例對,大模型可以更好地實現(xiàn)這些修改目標(biāo)。因此,我們通過構(gòu)建毒性詞空間、基于無毒樣例構(gòu)造毒性樣例、無毒/毒性樣例對翻轉(zhuǎn)等步驟構(gòu)建面向社交用戶的個性化修改樣例對,如圖2所示,以此提升基于ChatGPT的個性化修改器的效果。

圖2 個性化修改樣例對構(gòu)造過程

小結(jié)

本研究中,我們開發(fā)了DeMod,一個集成可解釋檢測與個性化修改功能的整體性毒性內(nèi)容審查工具。通過提供多種解釋和修改建議,DeMod減輕了社交用戶的審查負(fù)擔(dān),并提升了他們的使用體驗。廣泛的評估表明,DeMod在功能豐富性、審查性能和易用性等方面具有多重優(yōu)勢。作為第一個研究整體性毒性內(nèi)容審查的工作,DeMod也存在一些局限性。例如, DeMod目前僅支持文本模態(tài)的毒性內(nèi)容審查以及僅在微博平臺上進(jìn)行評估驗證,限制了對多模態(tài)內(nèi)容以及不同社交平臺的普遍性研究。因此未來,我們將專注于提升DeMod對多模態(tài)內(nèi)容的審查能力,并拓展其在更多場景中的應(yīng)用。

作者信息

如果您對本文內(nèi)容感興趣的話,可以與作者聯(lián)系:

李亞瓊 復(fù)旦大學(xué)計算機(jī)學(xué)院協(xié)同信息與系統(tǒng)實驗室 博士研究生

研究方向:社交內(nèi)容審核、CSCW、人機(jī)交互

聯(lián)系方式:liyq22@m.fudan.edu.cn

評論 0